多智能体系统的协同基础

多智能体系统的核心概念与协同定义

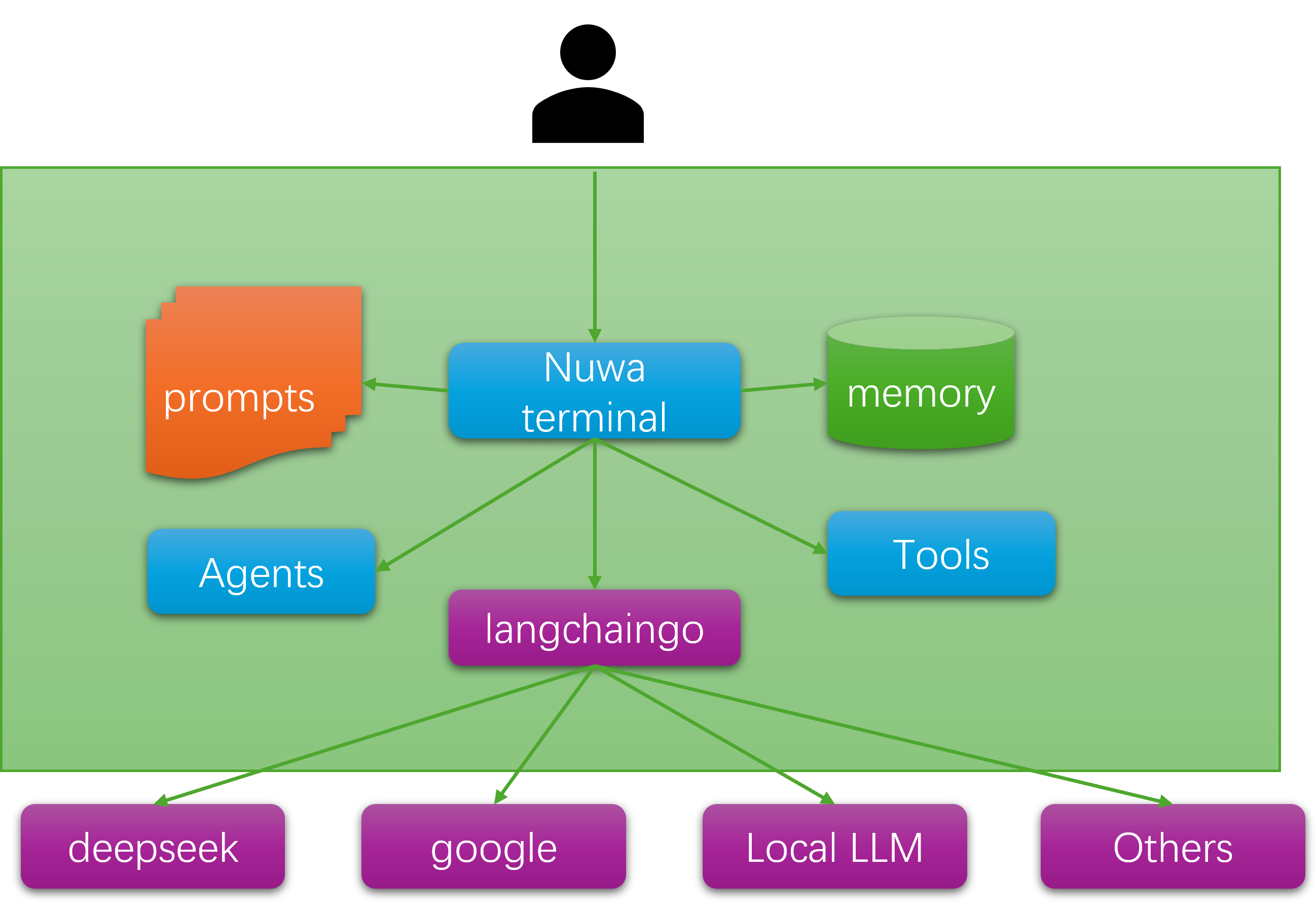

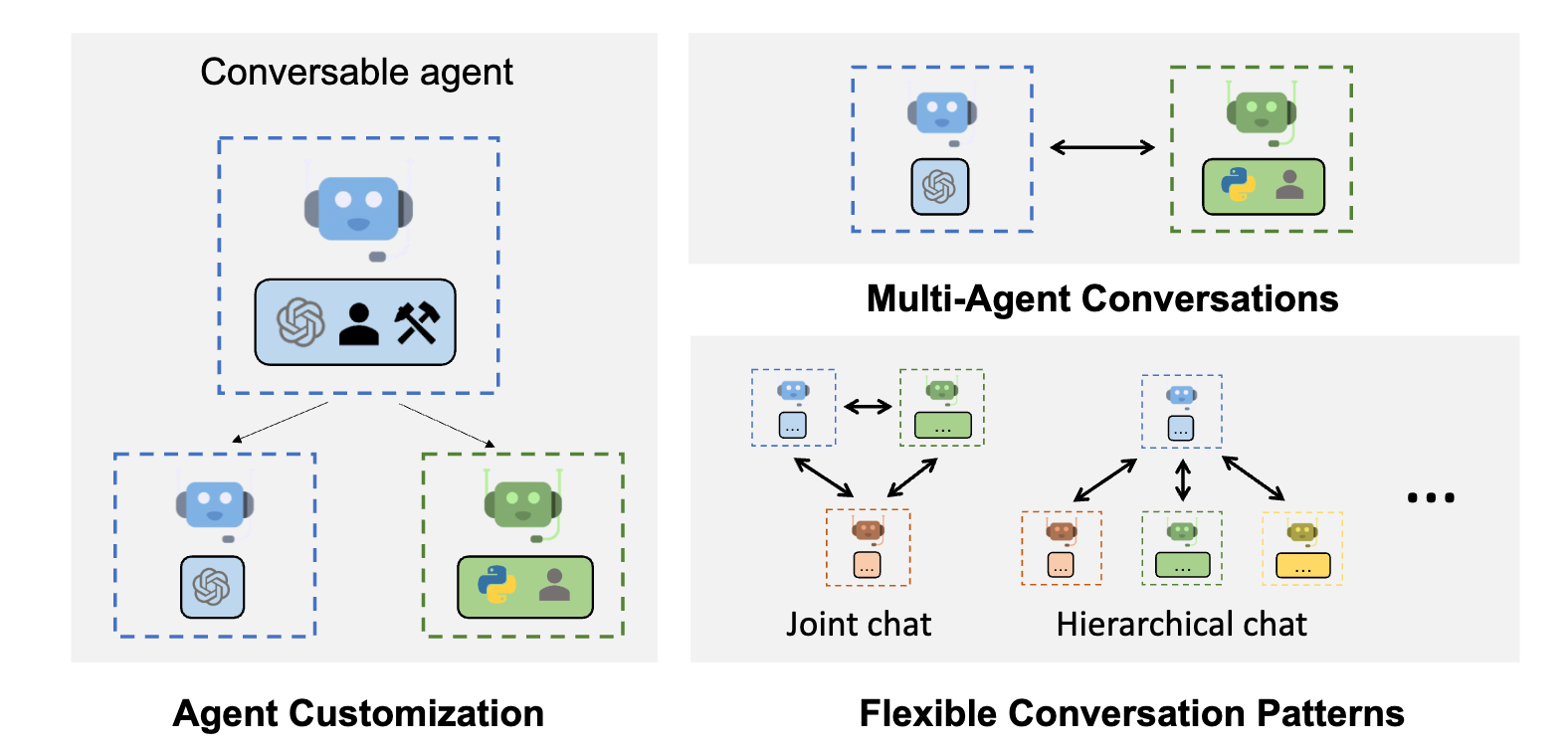

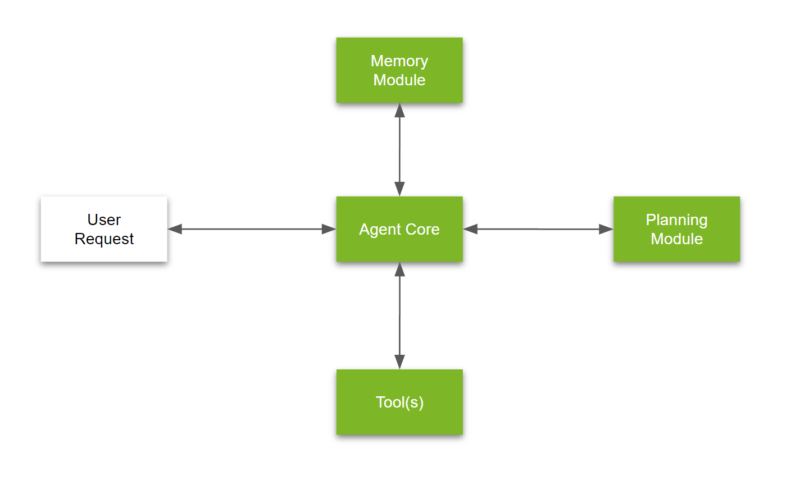

多智能体系统(Multi-agent System, MAS)是一个由多个独立的人工智能(AI)智能体组成的计算框架,其核心目标是让这些智能体通过协同工作来代表用户或系统执行复杂的任务 。系统中的每个智能体都拥有独立的属性,但它们会相互合作,以实现所需的全局属性或集体目标 。MAS的核心智能体通常以大型语言模型(LLM)为“大脑”,利用LLM先进的自然语言处理技术来理解用户输入并做出响应 。

MAS的协同行为能够显著提升系统的准确性、适应性和可扩展性 。与传统的单智能体系统相比,MAS能够胜任涉及数百甚至数千个智能体的大规模、复杂任务 。通过创建一个更大的共享资源池以及优化和自动化功能,多智能体系统的性能往往优于单智能体系统 。智能体之间无需重复学习相同的策略,而是可以共享所获得的经验,从而优化时间复杂性和整体效率 。从技术角度看,多智能体协同被定义为分布式系统中多个独立智能体的协调行动,每个智能体拥有其局部知识和决策能力。这种合作通常包括一套用于任务分解、资源分配、冲突解决和协作规划的系统方法 。

单智能体与多智能体系统在协同中的本质区别

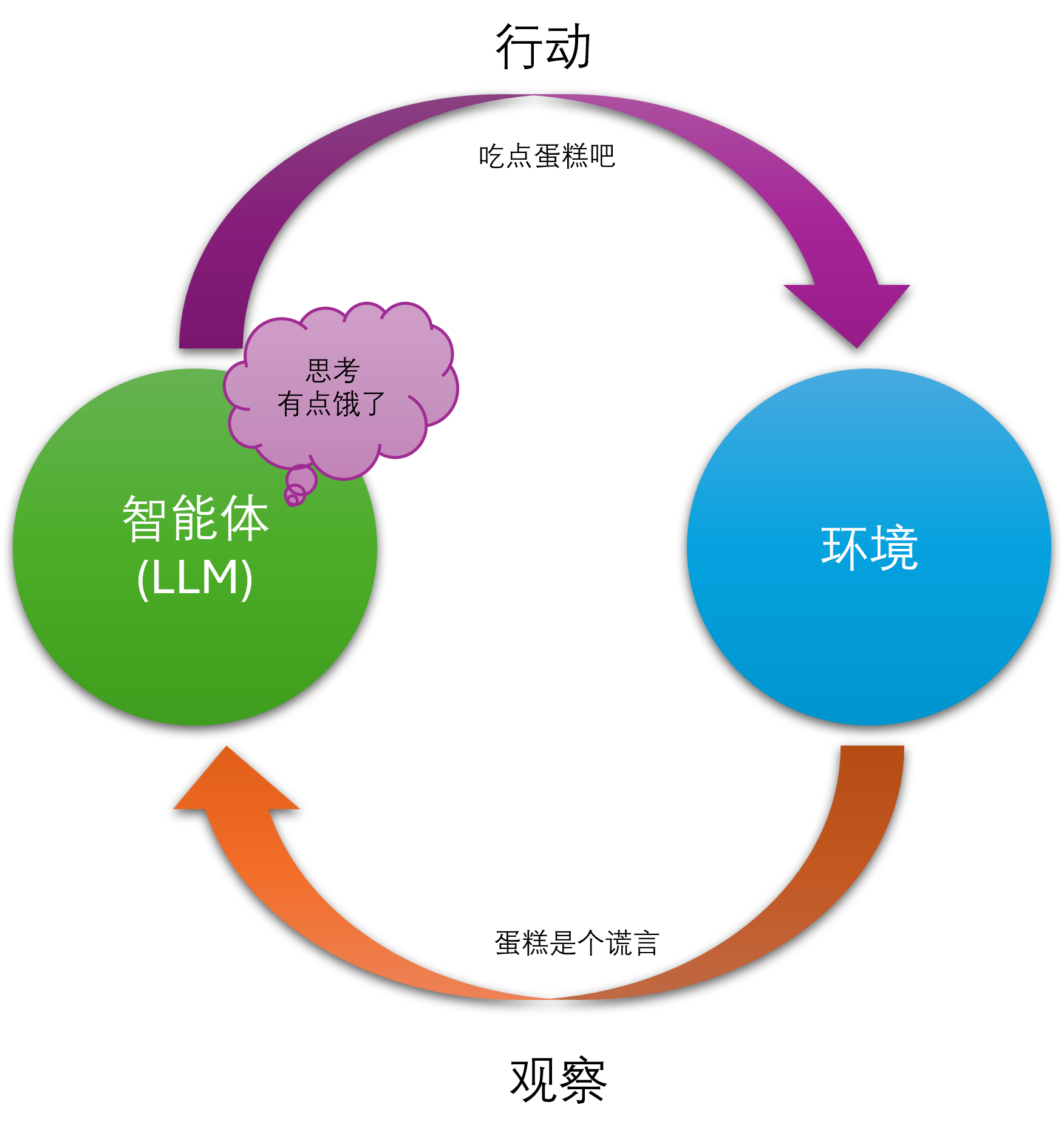

在理解多智能体协同的精髓时,区分它与单智能体系统的协作模式至关重要。在一个单智能体系统中,当一个智能体调用另一个智能体作为工具时,这个辅助智能体仅被视为原始智能体环境刺激的一部分 。原始智能体获取信息后,通常不会再发生进一步的合作。这是一种单向、工具性的调用关系,而非真正的协同。

多智能体系统则完全不同。其本质在于,环境内的所有智能体都能够对彼此的目标、记忆和行动计划进行建模 。每个智能体都保持一定程度的自主性,这通常体现在其规划、工具调用和一般推理能力上 。然而,它们会在一个统一的结构中进行合作与协调。这种能力使得智能体能够进行子任务的创建、工具的使用,并通过交互进行学习 。这种能够建模和理解其他智能体“意图”和“记忆”的能力,使得多智能体协同从单纯的规则驱动或数学模型驱动,向更接近人类社会协作的“意图理解驱动”转变。

这一转变的核心驱动力是大型语言模型(LLM)作为多智能体系统大脑的广泛应用 。LLM赋予了智能体强大的自然语言处理和高级推理能力,使其能够真正理解并模拟其他智能体的行为意图。因此,LLM的出现极大地降低了实现复杂多智能体协同的门槛,使得智能体能够进行更高级的交互,而不仅仅是简单的状态交换。MAS协同能力质变的关键技术正是LLM,它使得“意图理解”成为可能,从而催生了更加复杂和强大的协同模式。

多智能体协同的架构模式与策略

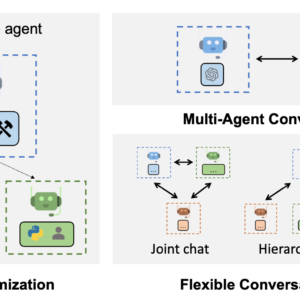

协同架构模式

多智能体系统可以在多种架构下运行,每种架构都代表了对系统控制、可扩展性、鲁棒性以及单点故障风险的权衡。理解这些架构模式对于设计高效、稳定的MAS至关重要。

中心化模式(Centralized Networks)

中心化网络依赖于一个中央单元(Orchestrator),该单元包含全局知识库,负责连接各个智能体并监督它们的信息 。这个中央协调单元的角色类似于项目经理或机场空管塔台 。中心化架构的优势在于智能体之间的通信简单直接,并且能够确保知识的统一性 。由于中央单元拥有全局视野,系统可以更容易地实现全局最优决策 。

然而,中心化模式存在明显的劣势。其主要弱点是对中央单元的依赖性:如果中心单元发生故障,整个智能体系统就会瘫痪,形成单一故障点 。此外,随着智能体数量的增加,中央单元可能成为性能瓶颈,导致可扩展性差 。因此,该模式更适用于任务结构化程度高、需要严格控制和全局一致决策的场景。

去中心化模式(Decentralized Networks)

去中心化网络中不存在单一的中央控制单元。智能体仅与其邻近的智能体共享信息,并根据本地信息自主做出决策 。这种点对点的模型具有高度的自组织性,系统的集体行为是基于个体间简单交互而形成的“涌现行为” 。例如,鸟类的群行行为就是去中心化控制下自组织和聚合的典型例子 。它们遵循简单的规则,如分离(避免与邻近鸟类碰撞)、对齐(匹配邻近鸟类的速度)和内聚(保持与其他鸟类的距离),从而实现同步飞行 。

去中心化架构的主要优点是其稳健性和模块化 。由于没有中央单元,某个智能体的故障并不会导致整个系统的失败 。同时,其可扩展性极高,增加更多智能体对系统性能的影响微乎其微 。但其挑战在于,由于缺乏全局视野,协调智能体的行为以实现全局最优变得困难,达成共识或协调也更为复杂 。尽管如此,在大型电力网络和城市交通信号控制等大规模系统中,去中心化模式可以显著降低风险,提高系统的稳定性和安全性 。

分层结构(Hierarchical Structure)

分层结构是一种树状架构,包含具有不同自主级别的智能体 。在这种模式下,一个智能体可以拥有决策权,并可以将责任分配给多个下级智能体。这种结构结合了中心化和去中心化的优点,在部分控制和自主性之间取得了平衡 。

多智能体架构模式的选择并非单一的技术决策,而是对系统核心需求(如控制精度、鲁棒性、可扩展性)进行深思熟虑后的一系列权衡。中心化模式倾向于在牺牲可用性和分区容错性的前提下实现高一致性,而这在需要严格控制的场景中是可取的。相反,去中心化模式则通过牺牲全局最优来换取高可用性和鲁棒性,这在需要处理大规模、动态环境的系统中至关重要。因此,成功的MAS设计需要深刻理解这些权衡,并根据任务特性(如复杂程度、规模、环境动态性)来选择或混合架构,而非盲目地追求某种“先进”模式。

协同策略与机制

除了架构之外,智能体之间如何具体进行交互和协调也至关重要。这通常通过预先设定的策略和机制来实现。

基于角色的协同(Role-based Collaboration)

基于角色的协同策略中,智能体被赋予特定的角色或职责,这些角色与一个清晰的组织或通信框架相吻合 。每个角色都带有一套特定的功能、权限和目标,这些通常与系统整体目标的不同部分相关联。这种概念借鉴了人类团队协作的动态,例如团队中的“领导者”、“观察者”或“执行者” 。

在一个基于角色的多智能体任务协同系统中,角色层被设计和实现,以在异构和动态变化的环境中动态分配任务,并提高集群系统的鲁棒性 。智能体可以根据分配的角色动态切换,以执行一个或多个子任务 。这种方法特别有利于任务分解、设计模块化系统,并使具有不同专长的智能体能够有效协作 。

基于规则的协同(Rule-based Collaboration)

基于规则的协同中,智能体之间的交互由一套特定的规则或指导方针严格控制 。这些规则通常以“if-then”语句、状态机或基于逻辑的框架实现,它们以可预测的方式规定了智能体如何行动、通信和做出选择 。这种方法最适用于高度结构化或可预测的任务,其中保持一致性是关键 。它的优势在于能够提供出色的效率和公平性,但其适应性和可扩展性较差,难以应对快速变化或复杂的情况 。

冲突解决与协商机制

在多智能体系统中,冲突是不可避免的,通常产生于智能体目标冲突、资源有限或对共享数据理解不同 。为了确保系统有效运行,MAS需要通过结构化的通信、决策协议和预定义规则来管理和解决冲突 。

解决冲突的主要方法包括:

协商(Negotiation): 智能体之间通过沟通提出建议和反建议,以达成双方可接受的结果 。例如,物流无人机可以协商航线以避免碰撞,或使用“Contract Net Protocol”协议通过投标方式动态分配任务 。这种协商对于与具有冲突目标的其他智能体合作时尤为重要 。

规则优先级(Rule-based Prioritization): 预定义的策略或规则决定如何解决冲突 。例如,在智能电网中,智能体可能遵循“优先使用可再生能源”的规则来分配电力需求 。

共识算法(Consensus Algorithms): 在去中心化系统中,智能体通过分布式算法(如Raft或Paxos)达成共享状态的一致性 。例如,区块链网络中的节点使用共识协议来验证交易。

博弈论(Game Theory): 在竞争模式下,智能体为争夺有限的资源或优势地位而行动,以获得最大的个体奖励 。多智能体协同控制问题可以被重新表述为微分博弈框架,每个智能体都试图优化自身目标函数,同时考虑其他智能体的行动 。

智能体之间的通信方式与协议

通信方式:直接与间接

多智能体之间的通信是实现协同的基础。这种通信可以分为两种基本方式:

直接通信(Direct Communication): 智能体之间通过消息传递(message passing)进行显式通信 。它们使用预设的通信协议来交换状态信息、分配任务和协调行动 。例如,无人机在搜救任务中通过无线网络交换GPS坐标和传感器读数 。

间接通信(Indirect Communication): 智能体通过改变共享环境来间接交流 。例如,一个智能体在共享的数字白板上留下结果,另一个智能体通过感知这个环境变化来获取信息并做出响应。这种方式模仿了自然界中通过环境改变进行交互的模式 。

多智能体通信协议的技术要素

多智能体通信协议定义了智能体之间进行高效通信的规则和格式 。一个完整的协议包含三个关键要素:

语法(Syntax): 指通信中使用的符号结构,即信息传递的格式 。

语义(Semantics): 指符号所代表的含义 。

语用(Pragmatics): 指符号如何被解释 。

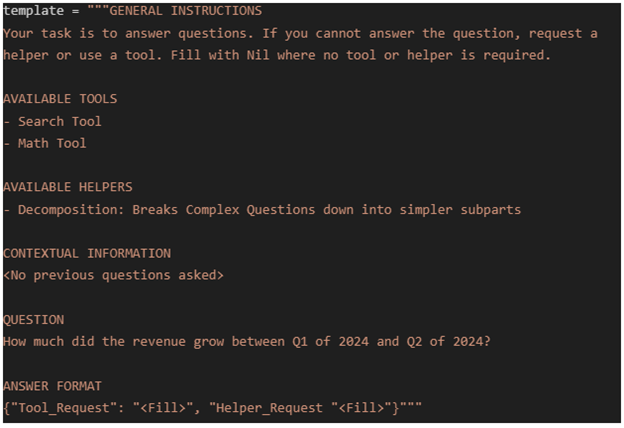

通过结合语义和语用,智能体可以理解信息的真正含义 。通信协议可以是

预定义协议,由开发者外部开发和更新;也可以是涌现协议,由智能体通过强化学习等方式自我发展出来 。预定义协议通常基于像FIPA-ACL这样的代理通信语言和本体论 。

现代与遗留通信协议深度分析

多智能体通信协议的演进与整个软件工程的架构范式演变高度同步。从早期的复杂、有状态的协议,到如今轻量级、无状态、面向云原生的协议,反映了技术社区对可扩展性、易用性和模块化的持续追求。

遗留协议(Legacy Protocols):

- FIPA-ACL: 这是一个在1996年建立的重大尝试,旨在通过形式化语义和言语行为理论来标准化代理通信 。它实现了20种基于模态逻辑的标准化“言语行为”,但其学术焦点、复杂性以及协议开销和有状态连接的限制,使其在现代云原生架构中难以被广泛采用 。

现代协议(Contemporary Protocols):

现代协议的兴起是云计算、微服务和API优先架构革命的直接结果 。它们从依赖正式本体论转向利用生成式AI进行动态解释。以下是几个代表性协议:

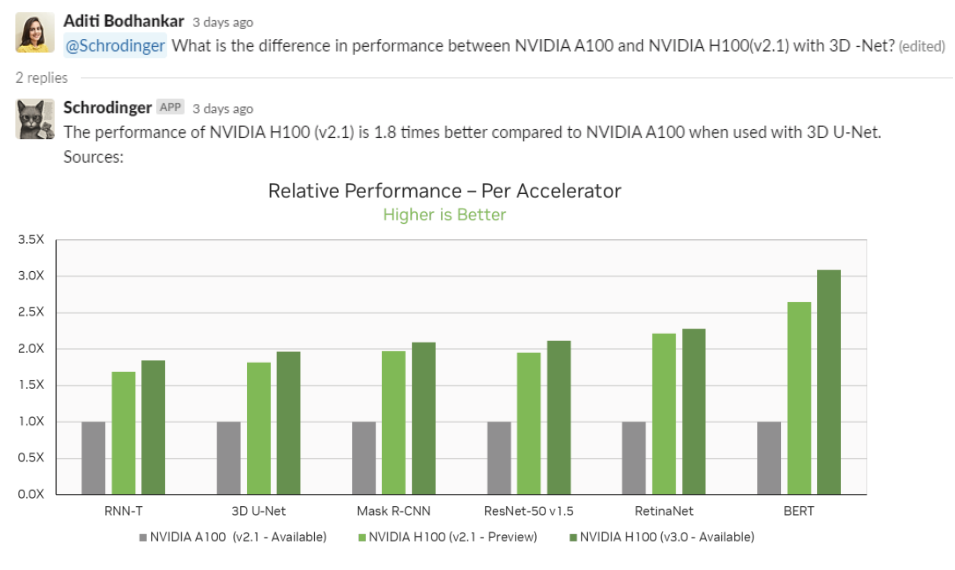

Model Context Protocol (MCP): 由Anthropic开发,采用客户端-服务器模型,通过JSON-RPC提供工具和数据访问的类型化模式 。该协议支持动态能力发现、以安全为中心的设计,并被誉为“AI界的USB-C” 。

Agent Communication Protocol (ACP): IBM Research开发的协议,基于RESTful HTTP架构,支持WebSocket流,并能通过MIME类型处理多模态内容 。ACP还提供了会话管理和内置的可观测性钩子,其安全模型基于能力令牌 。

Agent-to-Agent Protocol (A2A): Google Cloud开发,专为企业级智能体协作设计 。它使用JSON-RPC 2.0,通过“Agent Card”实现发现机制,支持OAuth2和mTLS等企业级认证方案,并着重于不共享内部状态的不透明通信 。

这些现代协议的设计哲学直接继承自微服务和Web API的成功实践,使得多智能体系统能够更好地融入现有的IT生态系统,实现更高效的互操作性。通信协议的演变不仅仅是技术细节的更新,更是其与主流软件工程实践深度融合的标志,使得MAS系统能够更加高效地构建和部署。

多智能体协同面临的挑战、局限性与未来展望

当前核心技术挑战

尽管多智能体系统展现出巨大潜力,但其发展仍面临多重挑战:

协调复杂性与行为不可预测性: 开发能够有效协调和协商的系统是一项基础性挑战 。在去中心化网络中,智能体的自主行为有时会产生冲突或变得难以预测,这使得问题的排查和解决变得异常复杂 。

故障传播与系统鲁棒性: 在依赖共享模型或知识库的系统中,某个智能体的错误或缺陷可能会在整个系统中蔓延,导致大范围故障或安全漏洞 。

“伪智能体”风险: 随着多智能体概念热度的攀升,市场上出现了一批将传统技术包装成“智能体”的现象,这误导了用户对MAS的认知和期望 。

伦理、安全与隐私挑战

多智能体系统的应用还带来了重要的伦理和社会挑战:

数据安全与隐私: 智能体对用户个人数据和商业机密的采集和分析,带来了重大的数据安全和隐私挑战。如何保护这些数据,并提高其存储、使用和分享的透明性,是开发者必须面对的关键任务 。

决策透明性: 智能体的决策过程可能缺乏透明度,难以进行审计和追责 。

控制与授权: 在模拟人类行为的虚拟社会中,必须建立审计日志和控制机制,确保被模拟的个体能够随时查看并控制其智能体的行为,并拥有撤销授权的权利 。

未来研究方向与发展趋势

未来的研究将继续聚焦于解决上述挑战,并推动多智能体协同能力的进一步发展:

开放环境下的多智能体强化学习(MARL): 传统的MARL研究主要在简单、静态和封闭的环境中进行。未来的发展方向是研究如何在动态、未知的开放环境中提升智能体团队的协作效能和稳健性 。

协同机制的理论框架: 研究将继续聚焦于多智能体协同的机制,例如如何通过博弈论、一致性控制等理论方法,实现纳什均衡(Nash equilibrium)的分布式搜索,以及在实际约束下设计有效的协同控制方法 。

自我组织与涌现智能: 多智能体系统的一个重要发展方向是,智能体能够基于简单的涌现行为规则进行自我组织,从而实现任务分工、协调决策和冲突解决,而无需人类的直接干预 。

跨模态、跨平台协同能力: 随着智能体被集成到更多的物理和数字环境中,其协同能力将需要扩展到处理多模态内容(如IBM的ACP协议所支持的)和跨平台的交互,从而实现更广泛的互操作性 。