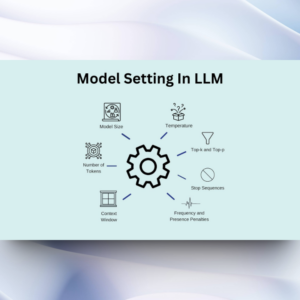

一文读懂LLM参数设置,实现大模型应用的最佳性能

引言

可以预见的是,通过生成模型,和通用模型,AI正在不断重塑整个数字化世界,在2024年我们看到LLM 应用像雨后春笋一样,基于LLM开发大模型应用已经逐渐成为程序员掌握的必备技能。

本文将重点介绍开发LLM 应用时,LLM基本参数的重要性,指导通过LLM 参数的设定可以提高应用的性能。

如何掌握temperature、top_p、max_length参数以实现最佳LLM表现?

在设计和测试LLM 应用的提示时,通常需要通过 API 与 LLM 进行交互。API可以配置一些参数以获得不同的提示结果。调整这些设置对于提高响应的可靠性和可取性非常重要,需要进行一些实验才能找出适合您用例的设置。以下文章内容将对不同LLM 之间常见的设置进行解释,并提供设置指导。

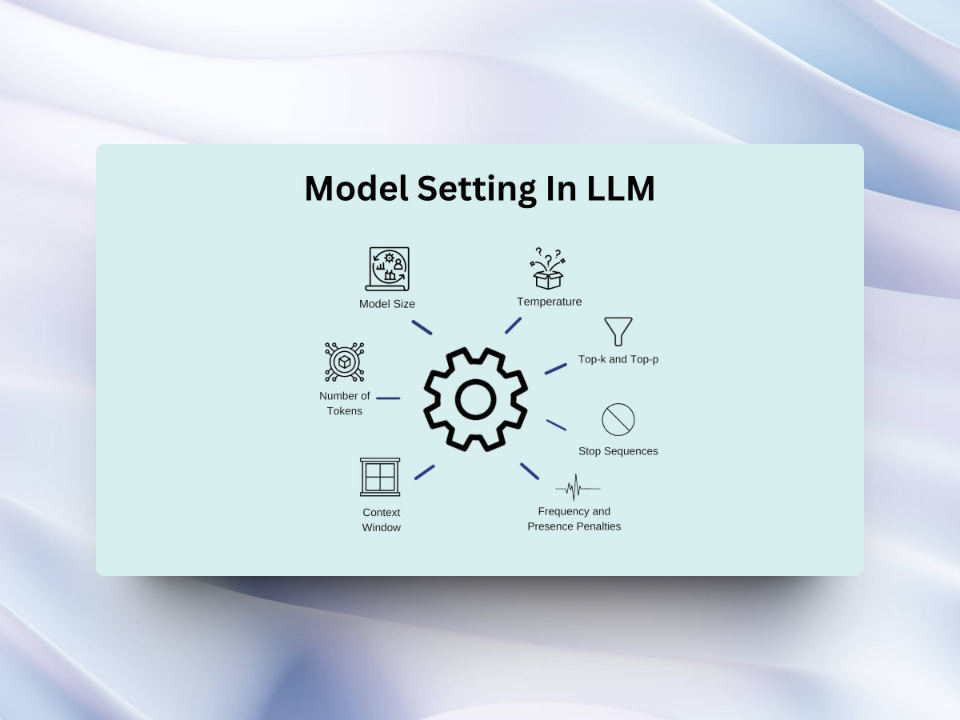

优化LLM性能的关键设置

温度

温度是一个控制模型输出随机性的基本设置。较低的温度通过偏向高概率标记使结果更具确定性,而较高的温度则引入更多变化性和创造性。

示例:

对于基于事实的任务(如回答问题或总结文本),较低的温度(如0.2)可确保简洁准确的回答。相比之下,对于创意写作任务(如诗歌生成或头脑风暴),较高的温度(如0.8)可以产生更多样化的输出。

要点

- 较低温度 = 更确定性的回答

- 较高温度 = 更具创意和多样性的回答

- 根据任务要求调整

Top P(核采样)

Top P通过仅考虑构成生成每个标记的顶级累积概率质量的标记子集来控制回答的多样性。

示例:

较低的Top P值(如0.1)将输出限制为高概率标记,适合生成事实性内容。较高的Top P值(如0.9)允许输出更多样化,适合需要创意的任务。

要点

- 低Top P = 自信精确的答案

- 高Top P = 多样化和创意输出

- 使用温度或Top P,但不要同时使用两者

最大长度

最大长度定义了对提示的回应中生成的标记数量。

示例:

设置适当的最大长度可以防止过长或无关的回答,同时控制与标记使用相关的成本。

要点

- 有效管理回答长度

- 防止无关或冗长的输出

- 通过控制标记使用优化成本

停止序列

停止序列是一个信号模型停止生成更多标记的字符串。

示例:

要生成不超过十个项目的列表,使用"11"作为停止序列,在列出十个项目后停止输出。

要点

- 精确控制回答长度

- 确保结构化输出

- 使用针对特定任务定制的停止序列

频率惩罚 & 存在惩罚

两种惩罚都减少重复,但应用方式不同:

- 频率惩罚:较高的值会抑制回答中重复的单词。

- 存在惩罚:对所有重复的标记施加相等的惩罚,不考虑频率。

示例:

对于多样化的文本生成,使用较高的惩罚;对于聚焦的内容重复控制,根据需求相应调整。

要点

- 频率惩罚按比例减少单词重复。

- 存在惩罚平等地抑制任何重复短语。

- 根据所需结果一次调整一个惩罚。

参考原文链接 :https://medium.com/@justmalhar/understanding-llm-settings-for-optimal-performance-83ee29c50392